Toute bonne stratégie de référencement SEO nécessite de comprendre comment les moteurs de recherche explorent votre site web. C’est là qu’intervient l’analyse de logs, une technique avancée permettant d’analyser les fichiers de logs générés par le serveur. Ces fichiers enregistrent chaque passage des robots, offrant des données précieuses sur le crawl et l’accessibilité de votre site.

Chez Zooka, nous savons que l’optimisation du crawl est un levier clé pour améliorer le référencement. En exploitant ces informations, il est possible d’identifier des erreurs, de repérer des opportunités et d’affiner votre stratégie SEO de manière efficace.

Dans cet article expert, nous verrons pourquoi l’analyse de logs est un pilier essentiel du SEO technique, comment récupérer et comment exploiter ces données pour optimiser votre stratégie de référencement web.

Qu’est-ce qu’une analyse de logs ?

Pour bien comprendre la notion d’analyse de logs, définissons dans un premier temps ce que sont les “logs”.

Les logs sont des enregistrements générés automatiquement par un serveur ou une application. Ces fichiers contiennent des données sur toutes les requêtes effectuées sur un site web, qu’elles proviennent d’un utilisateur humain ou d’un robot d’un moteur de recherche comme Googlebot.

L’analyse de logs consiste à étudier les logs serveur pour comprendre comment les robots explorent votre site, quelles pages sont visitées, et identifier d’éventuels problèmes qui pourraient nuire à votre bon référencement. Contrairement aux outils classiques de suivi de crawl qui fournissent des estimations, l’analyse de logs offre une vision 100% fiable et exhaustive du comportement des robots sur votre site.

Faire une analyse de logs pour comprendre le comportement des robots de moteur de recherche

Les moteurs de recherche comme Googlebot parcourent les sites pour collecter et indexer son contenu. Grâce à l’analyse de logs, vous pouvez répondre à certaines questions stratégiques :

- Quelles sont les pages les plus explorées ?

- À quelle fréquence les robots explorent-ils le site ?

- Des pages importantes sont-elles ignorées par les robots ?

Ces éléments et données peuvent vous offrir des premières pistes et axes d’améliorations pour faciliter l’exploration de votre site et favoriser une meilleure indexation et un meilleur positionnement de vos pages web.

Faire une analyse de logs pour identifier les problèmes de crawl

Le crawl est l’exploration d’un site par les robots des moteurs de recherche. Des erreurs de crawl peuvent empêcher la bonne indexation de certaines pages, pouvant ainsi impacter votre visibilité dans les SERPs.

Lorsque vous effectuez une analyse de logs vous pouvez détecter certains problèmes comme des erreurs HTTP (4XX, 5XX…), des redirections ou chaîne de redirections pouvant non seulement ralentir le crawl mais aussi nuir à l’expérience utilisateur, ou encore remonter des pages non explorées (malgré leur aspect stratégique pour votre visibilité).

Faire une analyse de logs pour optimiser le budget de crawl

Le budget de crawl correspond au nombre de pages qu’un moteur de recherche (comme Google par exemple) est prêt à explorer sur un site lors de son crawl. Le budget de crawl est une notion prioritaire pour tout expert en SEO, vous trouverez d’ailleurs une définition complète et des conseils pour l’optimiser dans notre glossaire dédié.

Il est important de comprendre que ce budget est limité et nécessite donc d’être utilisé de manière efficace. Les problèmes de crawl évoqués plus haut peuvent impacter le budget de crawl. L’analyse de logs vous permettra donc non seulement d’en savoir plus sur ce qui peut “coincer” lors du passage du crawler mais également d’agir en conséquence pour optimiser le budget de crawl qui est accordé à votre site. Vous pourrez remonter les pages qui “gaspillent” du budget de crawl, détecter les ressources bloquées qui peuvent empêcher une bonne exploration et optimiser la structure de votre site pour que les bots accèdent plus rapidement et facilement à vos pages les plus stratégiques.

Comment récupérer les fichiers logs pour faire une analyse ?

Les fichiers de logs sont enregistrés directement par le serveur sur lequel est hébergé votre site web. Ces derniers stockent l’ensemble des requêtes effectuées sur votre site, y compris celle des robots des moteurs de recherche (qui vont nous intéresser dans notre cas).

Pour récupérer ces fichiers il est nécessaire de passer par l’interface admin du serveur en question, par un logiciel de gestion d’hébergement ou d’une manière plus simple de demander l’accès aux fichiers à une équipe technique formée sur le sujet.

Certains outils permettent de récupérer et d’analyser les logs serveurs sans nécessiter de manipulations complexes. Cela peut être le cas d’outils intégrés directement aux serveurs, de certains outils d’analyse SEO ou de solutions cloud proposées par des plateformes dédiées.

Lors de l’extraction, pour un site moyen, et toujours dans le cadre de notre analyse de logs orientée SEO, l’idéal est de sélectionner une période d’une quinzaine de jours minimum pour cadrer l’analyse.

Quelle est la structure des fichiers de logs ?

Le fichier de logs peut être extrait dans plusieurs formats selon vos besoins et le niveau de technicité de l’analyse SEO. Parmi les plus populaires :

- .log ou .txt : qui sont les formats les plus courants et utilisés directement par les serveurs. Ces formats sont souvent ceux recommandés par les outils spécialisés dans l’analyse de logs.

- .csv : ce format est le plus simple à ouvrir (via Excel, Google Sheet, etc) et le plus pratique à interpréter sans outils ou compétences informatiques particulières.

- .json : format structuré et hiérarchisé, ce dernier est lisible uniquement par les outils d’analyses avancés (qui permettent par exemple d’automatiser l’analyse avec des API spécifiques).

Quels sont les éléments que vous pouvez trouver dans les fichiers de logs ?

Les fichiers de logs sont constitués de lignes de texte détaillant chaque interaction entre un serveur et un visiteur, dans notre cas les robots des moteurs de recherche. Ils contiennent plusieurs données clés qui permettent d’analyser le crawl, d’identifier des erreurs et d’optimiser le référencement. Voici une liste non exhaustive des principaux à prendre en compte pour une analyse de logs dans le cadre de l’optimisation de votre stratégie SEO.

L’user-agent

Le user-agent est une chaîne de texte qui permet d’identifier si la requête provient d’un navigateur, d’un robot d’indexation comme Googlebot ou Bingbot ou d’un outil tiers. Les fichiers de logs permettent ainsi de différencier :

- Le crawl mobile vs. desktop (Googlebot-Mobile vs. Googlebot-Desktop)

- Les robots d’indexation spécialisés (Googlebot-Image, Googlebot-Video, etc.)

- Les faux bots qui se font passer pour Googlebot mais qui ne proviennent pas de Google

Voici par exemple les 3 IPs des robots les plus répandus :

Chaîne user-agent GoogleBot Smartphone

Googlebot smartphone Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

Chaîne user-agent BingBot Smartphone

Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/112.0.0.0 Mobile Safari/537.36 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)

Chaîne user-agent ChatGPT

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0; +https://openai.com/bot

L’URL

Chaque requête concerne une URL spécifique, correspondant à une page web ou à un fichier (à voir dans le point suivant de l’article). L’analyse des URLs demandées permet ainsi de vérifier quelles pages web sont les plus explorées par les robots (et souvent de détecter des URLs inutiles ou sans valeur ajoutées qui consomment du budget de crawl) et par la même occasion d’identifier les pages peu explorées, voire ignorées par Google, qui peuvent nécessiter des optimisations.

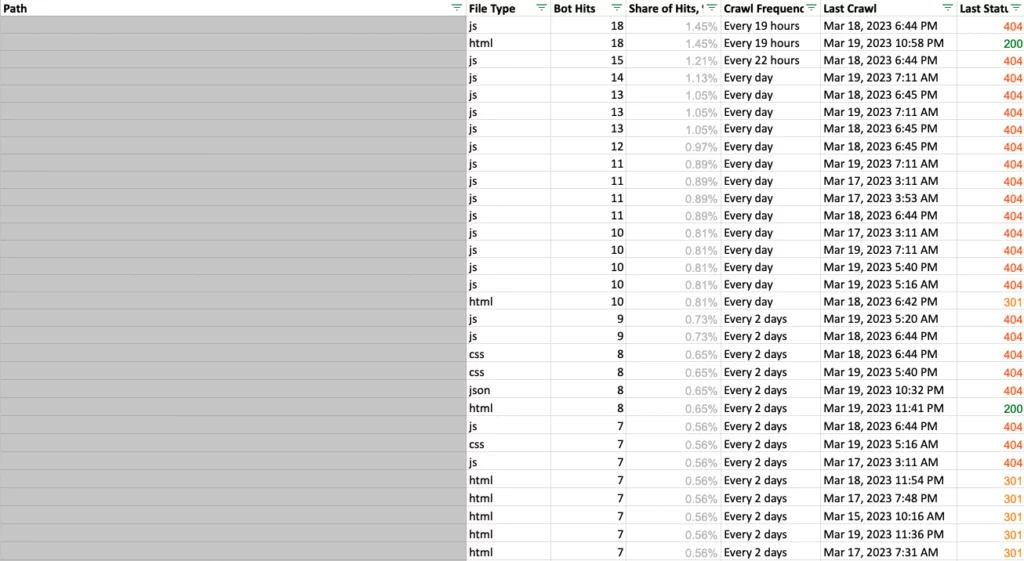

Le type de fichier

Les robots n’explorent pas seulement les pages HTML, mais aussi toutes les ressources associées (CSS, JavaScript, images, vidéos, etc.). L’analyse des fichiers demandés permet de repérer les ressources inutiles (souvent CSS ou JS, qui sont indispensables pour l’affichage et l’interaction mais qui peuvent surcharger et ralentir le crawl) ou qui consomment du budget de crawl, et d’optimiser l’accessibilité du site aux moteurs de recherche.

Le code réponse HTTP

Chaque requête reçoit un code de réponse du serveur, indiquant si la page a été servie correctement ou si une erreur s’est produite. Parmi les plus répandues :

- 200 (OK) : La page a été servie normalement

- 301 / 302 (Redirection) : La page a été redirigée, ce qui peut impacter le budget de crawl s’il y a trop de redirections en chaîne

- 404 (Not Found) : Une erreur qui signale une page supprimée ou mal configurée. Un excès de 404 peut nuire au référencement

- 500 (Internal Server Error) : Une erreur serveur qui peut ralentir ou empêcher l’exploration du site par Googlebot

La date et l’heure

Chaque ligne de log contient un “horodatage” précisant le moment exact où une page web ou une ressource a reçu un hit. Un “hit” correspond à chaque requête effectuée sur le serveur, que ce soit pour une page HTML, ou toute autre ressource. Les éléments une fois combinés permettront d’avoir accès à des informations essentielles à la compréhension du comportement des bots.

Le nombre de hits sur la période

Un nombre élevé de hits indique une forte activité des robots sur la page en question. Une répartition déséquilibrée des hits peut révéler des problèmes de crawl (trop de requêtes inutiles, gaspillage du budget de crawl) et à l’inverse une URL avec peu de hits démontre une ressource rarement explorée.

La fréquence de crawl sur la période

La fréquence de crawl correspond au nombre de fois où un robot d’indexation visite un site sur la période donnée. Un crawl trop faible pourrait indiquer un manque d’intérêt de Google pour certaines pages.

Quelles sont les bonnes pratiques pour une analyse de logs SEO efficace ?

Zooka, expert en SEO technique vous livre 3 bonnes pratiques à suivre pour maximiser l’impact de votre analyse de logs.

Une fréquence d’analyse adaptée

L’analyse des fichiers de logs ne doit pas être réalisée de manière ponctuelle, mais plutôt intégrée dans un suivi régulier. La fréquence idéale dépendra de plusieurs critères. S’ il s’agit d’un site e-commerce ou un site à fort trafic, celle-ci devrait être effectuée de manière mensuelle. Pour un site vitrine moyen ou un blog, une analyse de logs trimestrielle devrait suffire.

NB : L’analyse de logs est cruciale après une refonte, une migration SEO ou un changement technique majeur.

La mise en place de remontées automatiques

L’automatisation peut apparaître comme un levier clé pour gagner du temps et optimiser le traitement des données issues des fichiers de logs. Pour cela il existe de nombreux outils, gratuits ou payants selon les besoins.

Vous pouvez également mettre en place des alertes pour détecter les anomalies (pic d’erreurs 404, surcharge serveur, etc) ce qui vous permettra d’être informé immédiatement en cas de problème critique.

Le croisement des logs avec d’autres données

Bien que l’analyse de logs soit une bonne pratique pour prioriser les actions SEO techniques, son utilisation seule ne suffit pas. Il est essentiel de croiser ces données avec d’autres sources pour affiner les conclusions :

- Google Search Console (GSC), pour identifier les différences entre le crawl réel des robots et les URL indexées ou exclues

- Google Analytics 4 (GA4) pour comparer le comportement des utilisateurs avec celui des moteurs de recherche (ex. pages bien crawlées mais avec peu de trafic organique

- Un audit SEO, une solution hyper complète qui permettra de faire un état des lieux exhaustif de votre indexation par les moteurs de recherche et de mettre en évidence des pistes d’optimisations techniques

Plus de doute, l’analyse de logs est un levier puissant pour comprendre comment les robots des moteurs de recherche, notamment Googlebot, explorent un site web. Cependant, pour exploiter pleinement ces données, il est essentiel de structurer l’analyse et d’avoir une vision globale de son SEO technique. L’idéal est de réaliser des rapports détaillés avec des outils spécialisés comme Looker Studio, permettant de visualiser précisément les différents KPIs et leur évolution.

Pour aller plus loin et maximiser vos performances SEO, faites-vous accompagner par une agence experte comme Zooka ! Nos consultants vous aideront à interpréter vos données, à mettre en place les meilleures optimisations et à garantir un suivi SEO efficace et durable.