Lors d’un audit SEO, les experts du référencement parlent obligatoirement de mettre en place des solutions pour « optimiser le budget de crawl de Googlebot ». Pour les novices dans ce domaine, cela peut ressembler à du chinois. Pourtant, cette notion de référencement naturel est assez simple à comprendre une fois que les différents termes ont été explicités.

Voici quelques définitions et explications simples pour mieux comprendre les référenceurs qui vous entourent et assimiler cette notion essentielle du SEO.

Qu’est-ce que le budget de crawl ?

Avant de s’intéresser au budget de crawl et à son optimisation, commençons par définir ce qu’est un crawl.

Définition du crawl

Pour indexer et positionner un site dans ses pages de résultats, un moteur de recherche comme Google envoie des robots explorateurs (crawlers) sur les différentes pages du dit site. Les robots naviguent de page en page en suivant les liens présents qu’ils soient dans le menu, le footer ou le contenu. C’est cette action d’exploration des pages web que l’on appelle crawl.

Pour faire simple, lorsque les robots Google explorent votre site, dans le domaine du SEO on dit que Googlebot crawle votre site.

Cette exploration permet aux moteurs d’afficher la dernière version d’une page web dans leur index afin de proposer des sites à jour aux internautes qui effectuent des recherches.

Alors, comment savoir quand les bots explorent votre site ? C’est en réalisant une analyse de logs pour voir quel robot est passé sur quelle page et quand ou en menant des analyses poussées dans Google Analytics que vous allez trouver ces informations. Ces recherches demandent une certaine expertise technique et des connaissances approfondies en référencement et développement.

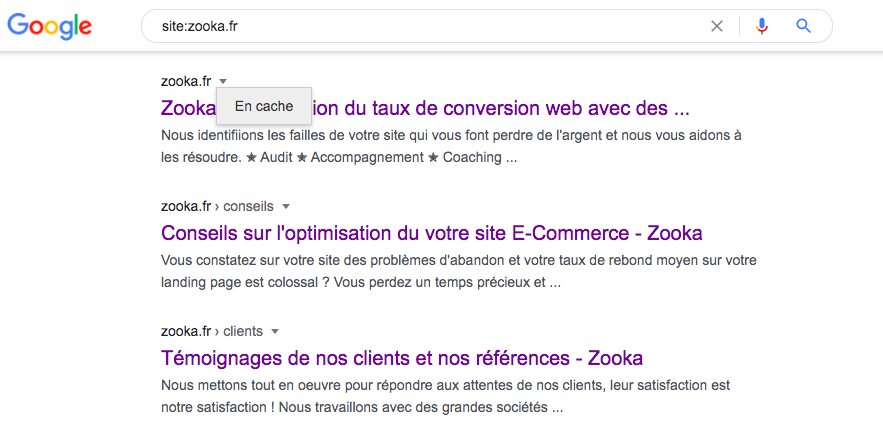

Par contre, vous pouvez savoir quand ils sont venus crawler pour la dernière fois de manière très simple ! Pour cela, il suffit de taper la commande « site : » suivi de l’URL que vous souhaitez dans la barre de recherche Google. Au lieu de cliquer sur le lien bleu, cliquez sur la petite flèche juste au-dessus puis sur « En cache » (dernière version de la page gardée en mémoire). Dans le bandeau gris en haut de page vous allez trouver la date et l’heure du dernier crawl du moteur.

Définition du budget de crawl

Le budget de crawl représente le nombre de page limite que Googlebot va crawler sur un site Internet.

Le concept de budget de crawl (ou crawl budget en anglais) réside dans le fait que les robots des moteurs de recherche n’explorent pas toutes les pages d’un site à chaque fois qu’ils le visitent. Ces bots vont devoir effectuer plusieurs visites pour explorer la totalité des pages d’un domaine.

Lors de leurs multiples explorations, ils prennent en compte plusieurs critères qui définissent la limite du nombre de pages explorées et donc le temps passé sur le site :

- Les performances du site et du serveur : plus un site est lent, moins l’exploration sera rapide et moins de pages seront visitées lors des crawls

- La profondeur : plus le nombre de clics pour atteindre une page est important, moins elle sera explorée car elle est difficilement accessible (le chemin pour l’atteindre nécessite de suivre beaucoup de liens)

- La fréquence de mise à jour : les robots vont moins souvent visiter un site statique qu’un site qui met ses contenus à jour régulièrement puisque pour lui, il n’est pas nécessaire de le visiter régulièrement pour proposer la dernière version

- La qualité du contenu : si le moteur de recherche estime que votre contenu est qualitatif, il reviendra plus souvent visiter vos pages.

Optimiser le budget de crawl : qu’est-ce que cela signifie concrètement ?

L’optimisation du budget de crawl désigne le fait de mettre en place des actions qui facilitent l’exploration des robots crawlers afin qu’ils visitent un maximum de pages de votre site à chaque passage.

Imaginez que chaque crawl coûte de l’argent à la firme de Mountain View (d’où l’expression de « bien dépenser le budget de crawl »). Pour faire en sorte que les robots ne perdent pas de temps à chaque visite il faut donc optimiser chacun des critères listés plus haut pour simplifier leur exploration.

Ainsi, si les crawls du moteur sont fluides et rapides, les robots vont favoriser l’exploration de votre site plutôt que celle d’un site lent, aux contenus peu qualitatifs et dont les pages sont difficilement accessibles.

L’optimisation du budget de crawl sert donc à faire en sorte que votre site soit souvent visité par Googlebot. In fine, l’objectif est que le moteur de recherche numéro 1 dans le monde repère et priorise vos pages les plus importantes et indexe rapidement vos nouvelles pages pour les positionner rapidement dans ses résultats de recherche.

Comment optimiser le budget de crawl de Googlebot ?

Pour optimiser le crawl budget des robots, il faut s’intéresser à la fois au côté technique d’un site et à son aspect sémantique.

Au niveau de l’audit SEO technique, vous allez devoir travailler sur les points suivants pour faire en sorte que les crawlers explorent régulièrement votre vitrine web :

- Les performances

- La qualité de l’indexation

- Le maillage interne

Au niveau sémantique, c’est sur la fréquence de mise à jour et la qualité du contenu que vous allez devoir travailler en priorité.

Optimiser la vitesse de son site

Plus un site est lent, plus un robot ou un utilisateur va perdre du temps pour accéder à une page. Et faire perdre du temps aux crawlers est synonyme de gaspillage pour tout moteur de recherche.

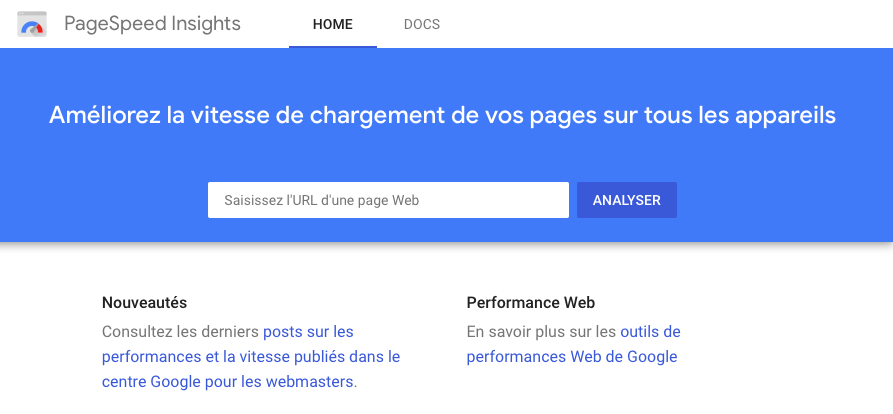

Vous vous posez forcément la question : Comment évaluer et optimiser vos performances ? Grâce à Google lui-même. La firme de Mountain View met à la disposition de tous un outil gratuit pour tester les performances de son site sur mobile et sur desktop : PageSpeed Insights.

En tapant votre nom de domaine dans l’outil, vous pouvez tester ses performances et obtenir des données très utiles à l’optimisation technique de votre site.

Google vous fournira même des recommandations pour être plus performant sur chacun des points testés comme le Speed Index ou les Web Vitals.

La qualité de l’indexation

Pour que les robots passent le plus de temps possible sur vos pages stratégiques, pensez à soigner l’indexation de votre site. Utilisez donc pour cela un émulateur de Googlebot, c’est-à-dire un outil qui crawle votre site à la manière des robots Google et vous bâtit des rapports complets sur votre indexation.

Les 404 ou autres codes serveur 4XX et 5XX sont des mauvais signaux envoyés aux moteurs de recherches. Ils estiment alors que votre site n’est pas propre techniquement, que votre serveur est instable et favoriseront sans doute celui d’un concurrent dans leurs résultats de recherche. Supprimez donc vos pages d’erreur de l’index Google en affichant un code serveur 410 Gone ou en mettant en place des redirections.

Pensez à faire en sorte que seules les pages utiles, celles qui ont un réel intérêt SEO et pour les utilisateurs fassent partie de l’index Google. Utilisez les données de l’émulateur pour identifier toutes les pages indexées et ajoutez des balises <noindex> sur les pages qui ne présentent aucun intérêt stratégique.

Pour checker le nombre de pages de votre site qui sont indexées par Google vous pouvez taper « site:https://nomdedomainedevotresite.com » dans la barre de recherche.

Pensez également à nettoyer votre fichier sitemap pour éviter qu’il indique aux moteurs de visiter des pages que vous ne souhaitez pas indexer.

Grâce à ce nettoyage de l’indexation, vous vous assurer que les crawlers visitent seulement les pages que vous souhaitez positionner dans les résultats et vous optimisez le budget de crawl du robot.

Le maillage interne

Le maillage interne désigne le fait de créer des liens entre vos différentes pages. Ce facteur est tout bonnement important puisque c’est en suivant les liens que les robots accèdent aux différentes pages d’un site.

Créez donc des liens logiques entre vos pages pour guider les crawlers lors de l’exploration.

Ce processus est très stratégique pour faciliter le crawl de vos pages profondes dont l’accessibilité nécessite un nombre de clics important et mettre en avant vos pages principales.

La fréquence de publication

Les robots crawlers viendront plus souvent visiter votre site s’ils rencontrent régulièrement de nouveaux contenus. Les moteurs sont sensibles à la fraicheur des contenus.

Publiez régulièrement des articles de blog et de nouvelles pages et adaptez l’existant pour indiquer à Google que votre site vit et que vos contenus sont régulièrement mis à jour.

La qualité des contenus

La fraicheur est un facteur de crawl important mais ce n’est pas seulement cet aspect du contenu qui compte pour lui : la qualité l’est tout autant, voire davantage. Proposer aux utilisateurs des contenus de qualité et qui répondent à de réelles intentions de recherche est primordial.

Pour cela, ciblez des mots clés pertinents qui sont en relation avec la thématique de votre activité. Rédigez de longs articles en abordant le sujet sous un angle novateur pour susciter l’intérêt de l’internaute et apporter une réelle valeur ajoutée.

En savoir plus sur la rédaction SEO

La qualité des contenus passe bien entendu par l’aspect qualitatif de vos textes mais aussi par le fait qu’ils soient linkés par d’autres sites de vos domaines d’expertise et géographique. Travaillez donc le netlinking pour booster les contenus que vous jugez les plus stratégiques et votre nom de domaine. Plus un site reçoit de lien, plus il fait autorité dans son milieu pour Google et plus ses contenus sont censés être qualitatifs. L’autorité fait d’ailleurs partie du principe EAT qui liste trois critères essentiels pour Google pour évaluer la pertinence d’un site : Expertise, Authoritativeness, Trustworthiness pour Expertise, Autorité et Confiance.

De plus, en explorant les sites qui ajoutent des liens vers le vôtre, les robots crawlers ont d’autant plus de chances de visiter vos pages.

L’optimisation du budget de crawl est un élément essentiel de l’algorithme de ranking de Google puisqu’il consiste à faciliter l’exploration du site. Si la firme estime que vous faites en sorte de lui proposer des contenus qualitatifs, frais et que votre site est performant, ce dernier sera d’autant plus visité.